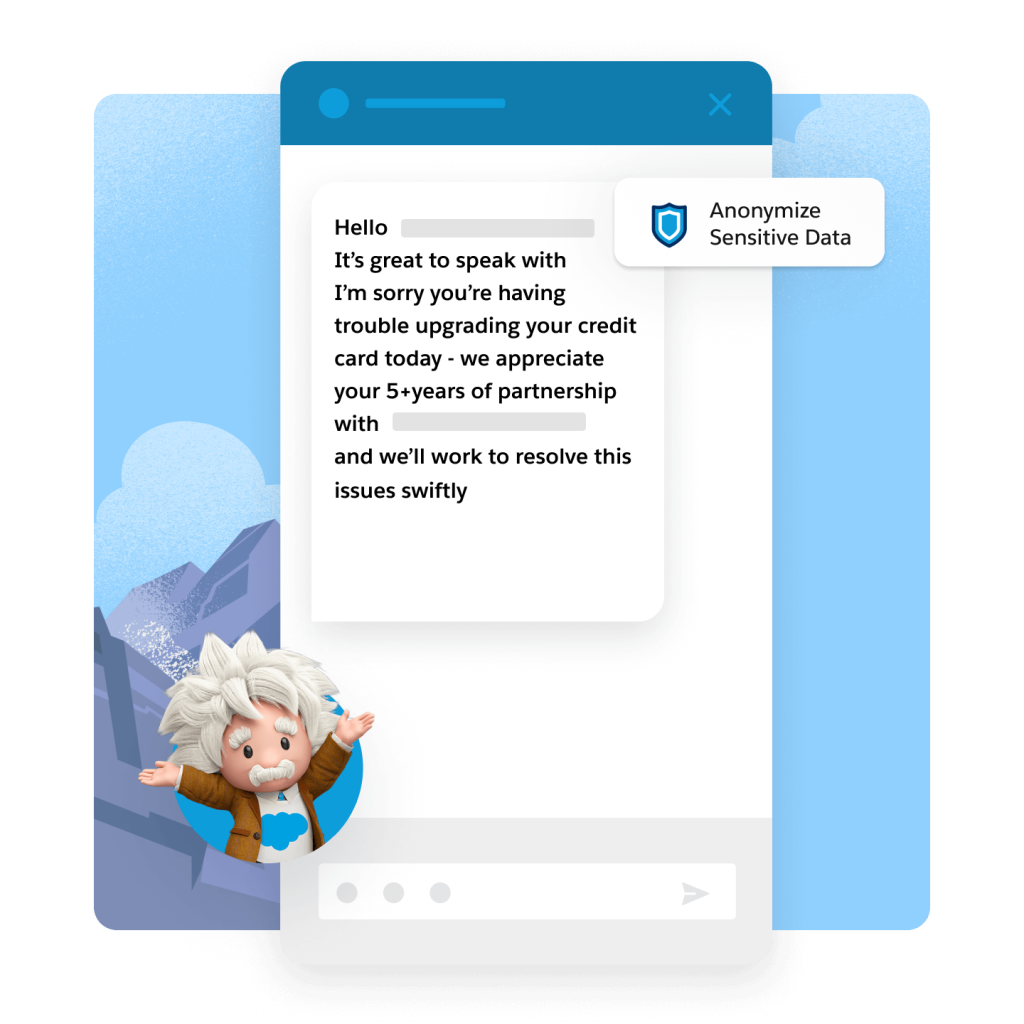

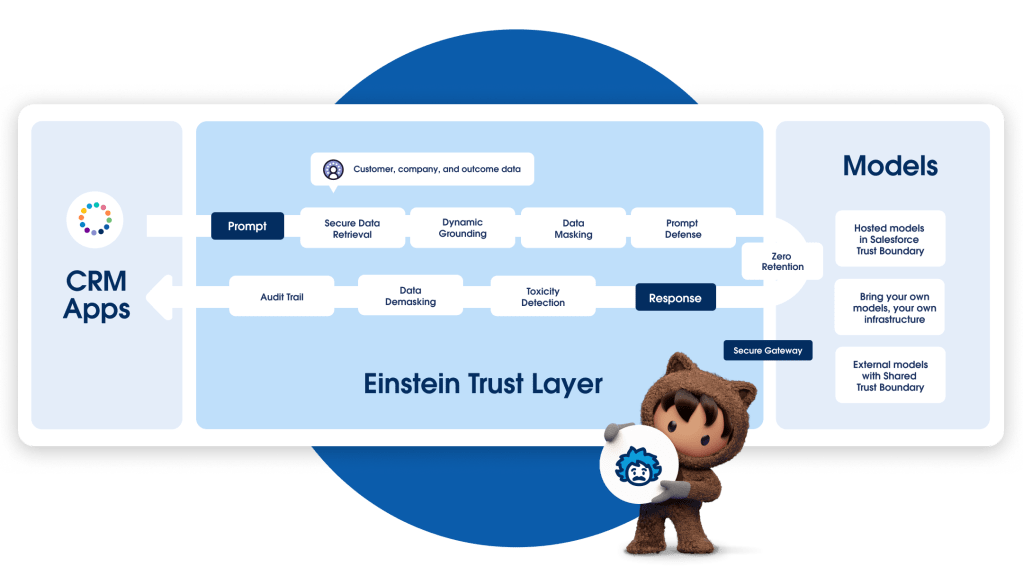

Einstein Trust Layer

Einstein Trust Layer è un'architettura AI sicura, integrata in modo nativo in Salesforce Platform. Sviluppato su Hyperforce per la residenza e la conformità dei dati, Einstein Trust Layer è dotato delle migliori barriere di sicurezza della categoria, dal prodotto alle nostre policy. Progettato per standard di sicurezza di livello aziendale, Einstein Trust Layer consente ai team di trarre vantaggio dall'intelligenza artificiale generativa senza compromettere i dati dei clienti.