Einstein Trust Layer

Einstein Trust Layerは、Salesforce Platformにネイティブに組み込まれた、安全なAIアーキテクチャ。データレジデンシーおよびコンプライアンス要件への対応のため、Hyperforce上で稼働するEinstein Trust Layerは、製品の品質から開発ポリシーまで、業界屈指の安全性を実現しています。公正な倫理観に則った、安全で、偏りのないAIでありながら、品質に妥協のないEinsteinをお試しください。

Einstein Trust Layerは、Salesforce Platformにネイティブに組み込まれた、安全なAIアーキテクチャ。データレジデンシーおよびコンプライアンス要件への対応のため、Hyperforce上で稼働するEinstein Trust Layerは、製品の品質から開発ポリシーまで、業界屈指の安全性を実現しています。公正な倫理観に則った、安全で、偏りのないAIでありながら、品質に妥協のないEinsteinをお試しください。

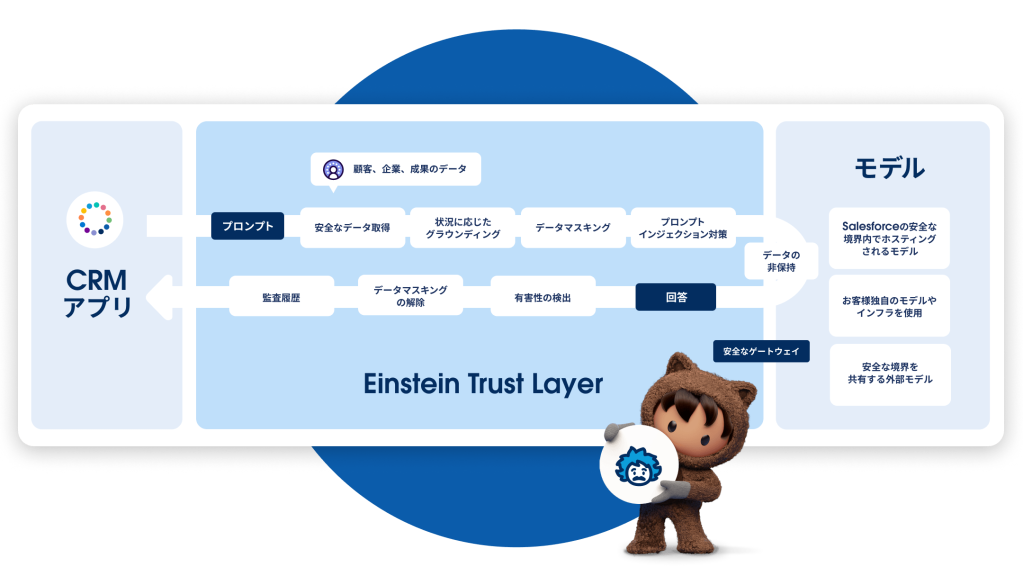

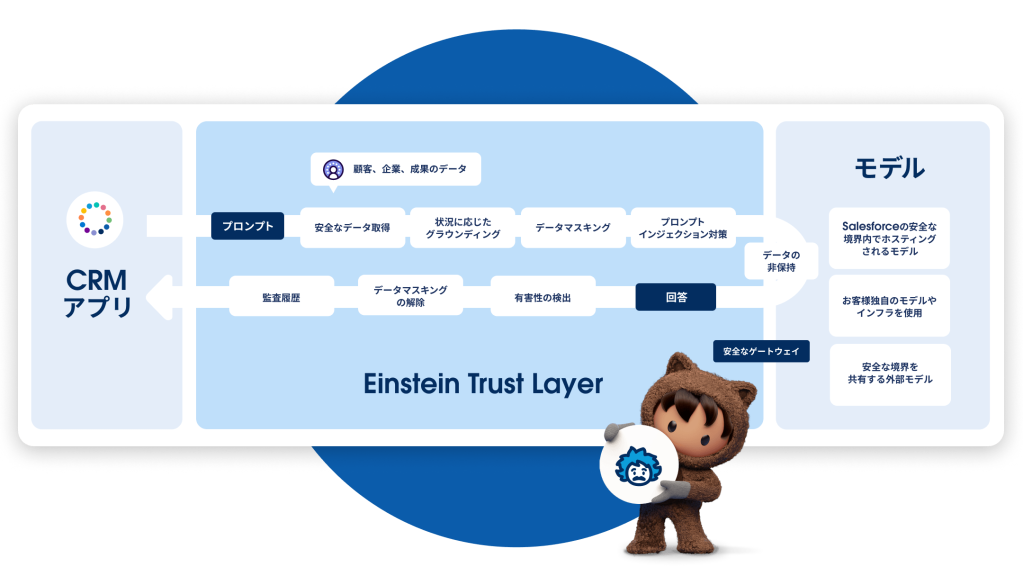

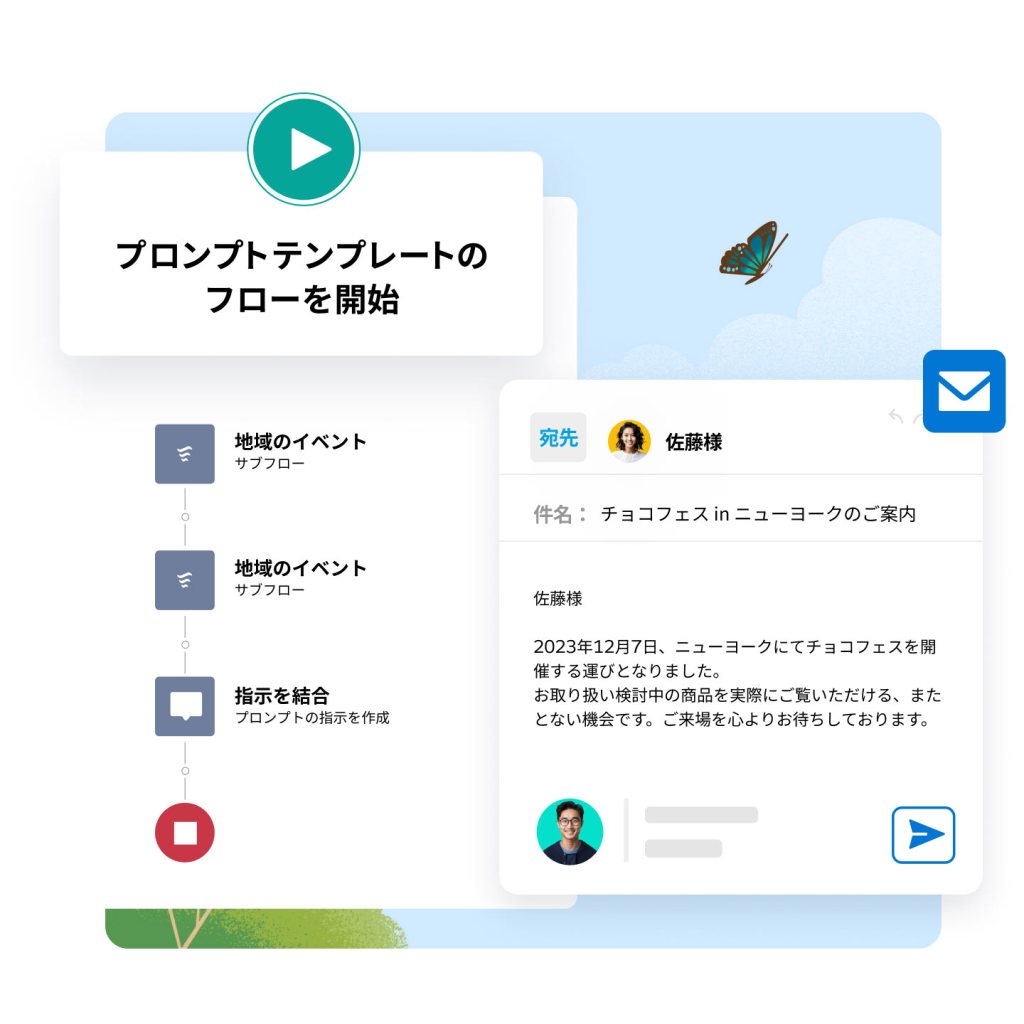

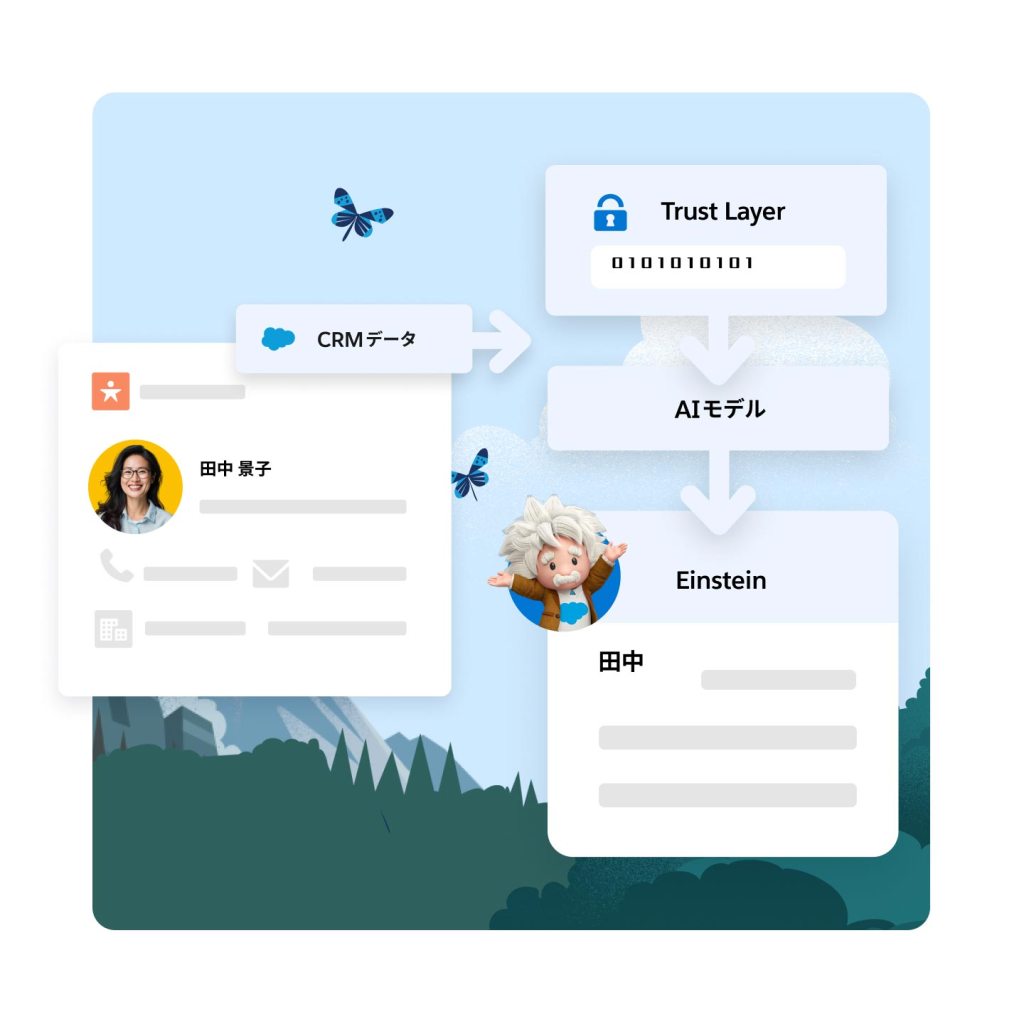

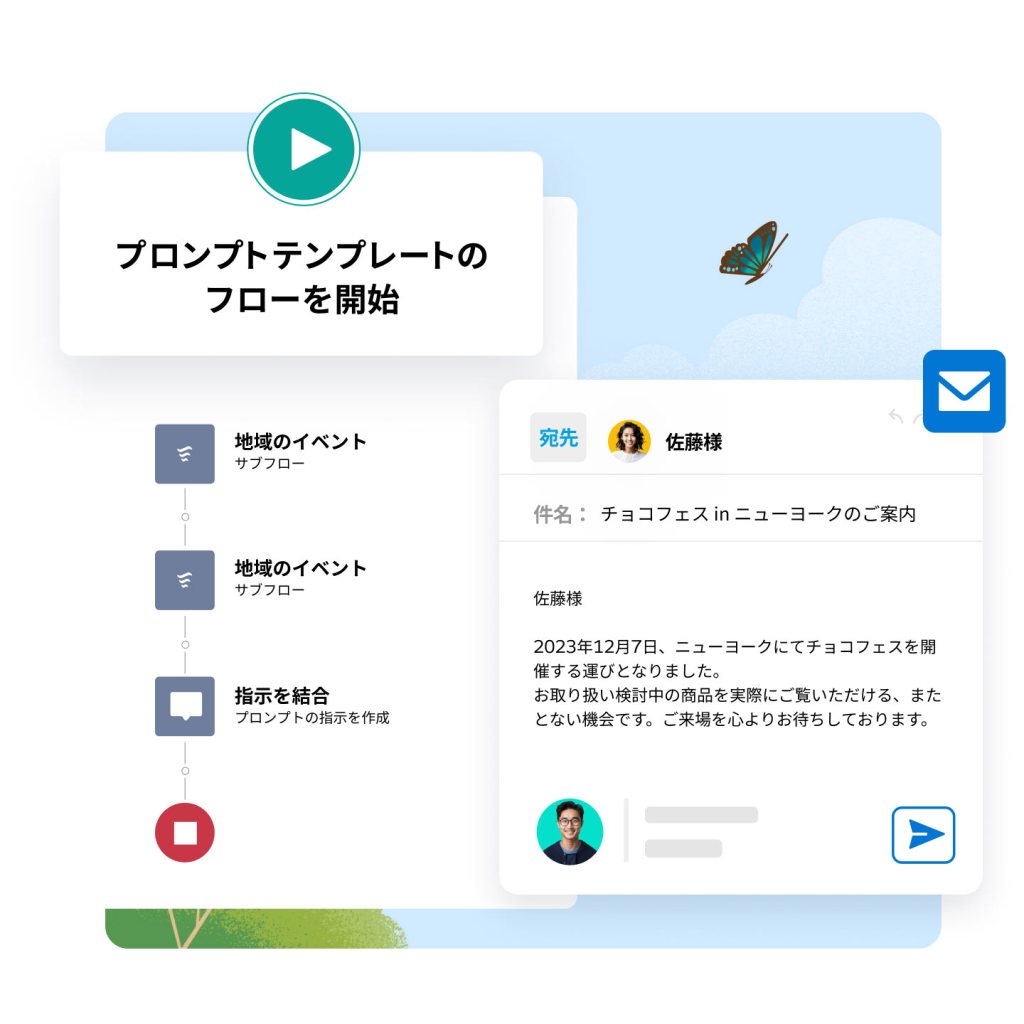

プロンプトは、詳細なコンテキストと指示を大規模言語モデルに伝えるキャンバスです。Einstein Trust layerを使用すると、顧客データのすべてのプロンプトを責任を持ってグラウンディングし、プロンプトを大規模言語モデルと共有する際はデータをマスキングできます。ゼロリテンションアーキテクチャにより、データがSalesforceの外部で保管されることはありません。

* 近日リリース予定

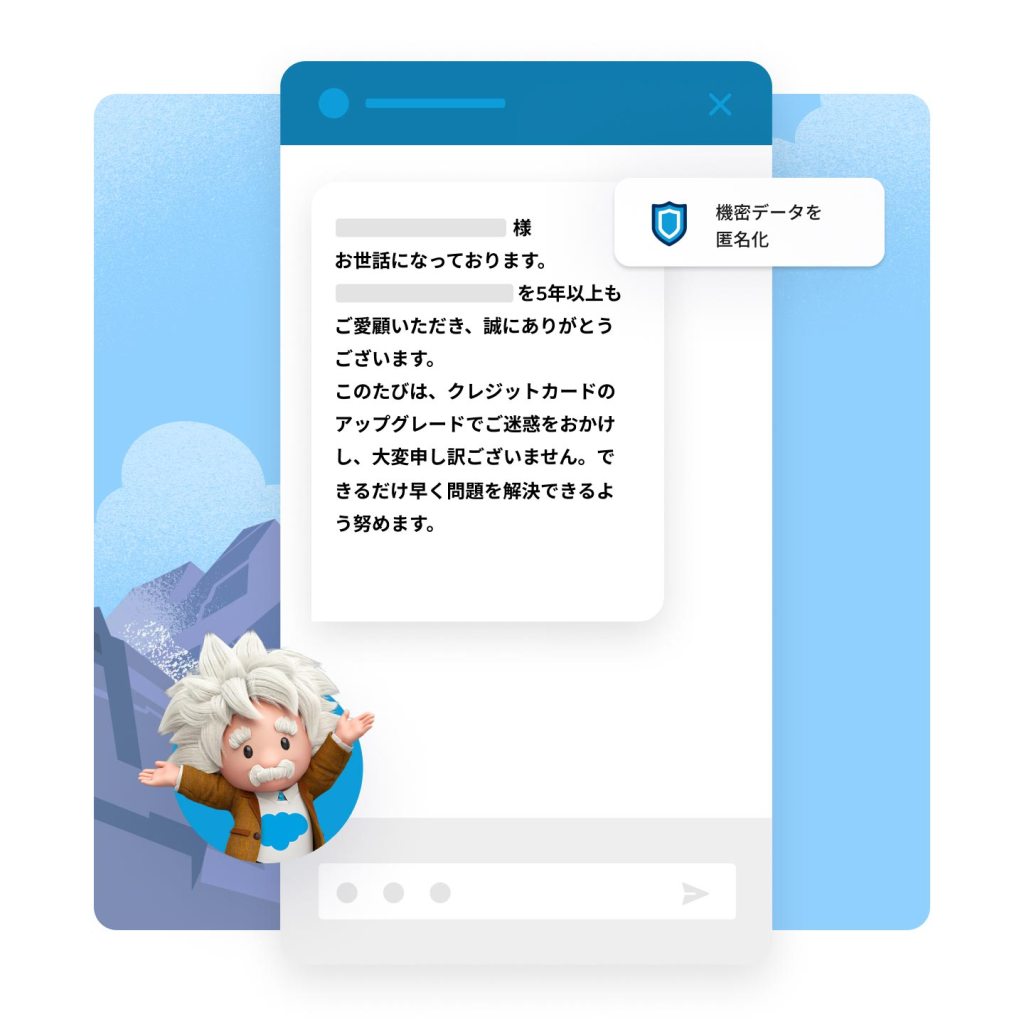

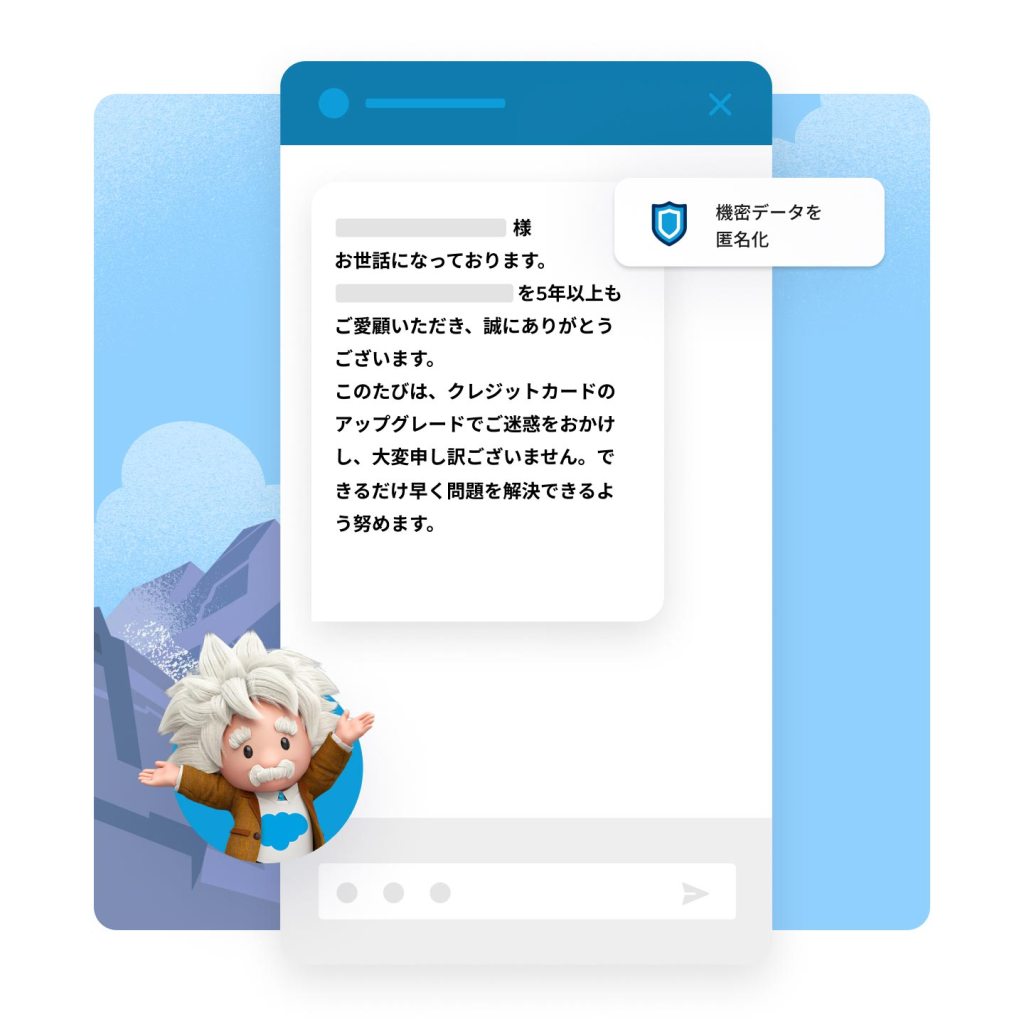

機密データを外部の大規模言語モデルから自動的に保護します。

学習すべき関連データの種類、品質、範囲で生成AIプロンプトに安全にアクセスして動的にグラウンディングし、もっとも信頼できる出力を得ます。フィールドをSalesforceレコードと安全に結合し、セマンティック検索を使用して、サポートナレッジ記事から関連情報を取り込むことができます。

ドメイン固有の知識と顧客情報をプロンプトに追加し、より正確な応答に必要なコンテキストをモデルにもたらします。CRMデータ、ナレッジ記事、サービスチャットなどからコンテキストを追加することで「幻覚」が出力される可能性を下げることができます。そのデータを自動的に取得して使用することで、信頼できる応答を生成できます。

*近日リリース予定

プロンプトで使用されるデータをマスキングし、新たな保護階層を追加します。PIIや支払いデータを自動的に検知し、大規模言語モデルに反映する前にプロンプトから抹消します。応答の作成後にそのデータのマスキングを解除し、内部ユーザーと適切なコンテキストを共有できるようにします。

Salesforceでは、AIにおける顧客データの使用方法を顧客自身が管理できます。Salesforceがホストするモデルを使用する場合も、OpenAIなどの共有信頼境界の一部となる外部モデルを使用する場合も、コンテキストは保存されません。大規模言語モデルは、出力を処理すると同時にプロンプトと出力を消去します。

すべてのプロンプトと出力の有害性をスキャンしてスコアリングすることで、従業員による不適切または有害なコンテンツの共有を未然に防ぐことができます。人間が承認または却下する前に出力が共有されないようにし、すべてのステップをメタデータとして監査証跡に記録することで、広範囲でシンプルにコンプライアンスを維持できるようにします。*

*近日リリース予定

Salesforceは、特にデータとAIについて、倫理的・人道的な使用を意図的に組み込んだソフトウェアとソリューションの提供に取り組んでいます。お客様とユーザーが責任を持ってAIを使用できるように、もっともリスクが高い分野に対応したAI Acceptible Use Policy(AI利用規定)を策定しました。個人に合わせた医療、法律、財務関連の助言の生成は、こうした分野での人間による意思決定を維持するために禁じられています。Salesforceでは、自社製品の現実世界に対する影響に配慮し、具体的な保護対策を講じています。これは、当社の価値を維持しながら、最新のツールを市場にお届けすることでお客様をサポートすることが狙いです。

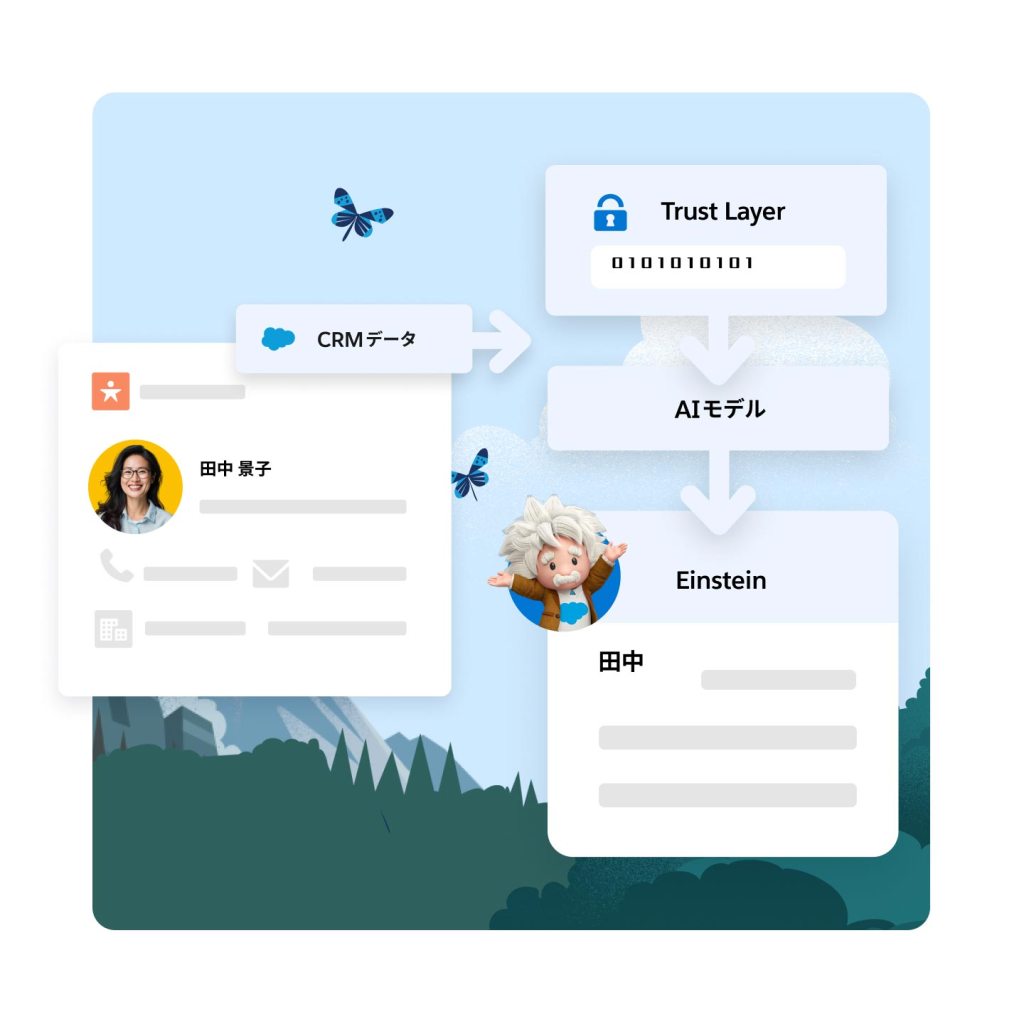

安全なAIとは、出力の質を落とすことなく、顧客データを保護するAIのことです。顧客データと企業データは、AIモデルの結果を強化し、パーソナライズするための鍵になりますが、データの使用方法について信頼を得ることも重要です。

AIの安全性に関する懸念としては、データプライバシーとセキュリティが上位に挙がります。多くの顧客は自分のデータを預ける企業を信頼していません。特に、生成AIには、精度や有害性、生成されるコンテンツの偏りといった新たな懸念もあります。

Salesforceは、Einstein Trust LayerをPlatformに直接組み込むことで、顧客データのセキュリティを保っています。Einstein Trust Layerには、データマスキング、TLSインフライト暗号化、大規模言語モデルでのゼロデータリテンションなど、多くのデータセキュリティガードレールがあります。

信頼できるAIを導入することで、データセキュリティやプライバシーコントロールを損なうことなく、AIのメリットを確実に得ることができます。Einstein Trust Layerは、データの移動先やデータにアクセスするユーザーを確実に把握することで、AIから最高の成果を引き出すことに集中できます。

まず、AIでビジネスニーズをどのように満たすのか把握し、ユースケースを明らかにします。次に、信頼性の高いAIソリューションを提供してきた、信頼できるパートナーを選択します。最後に、業界固有の規制やコンプライアンス要件を明らかにし、信頼できるAIジャーニーへのアプローチに反映させます。

*近日リリース予定