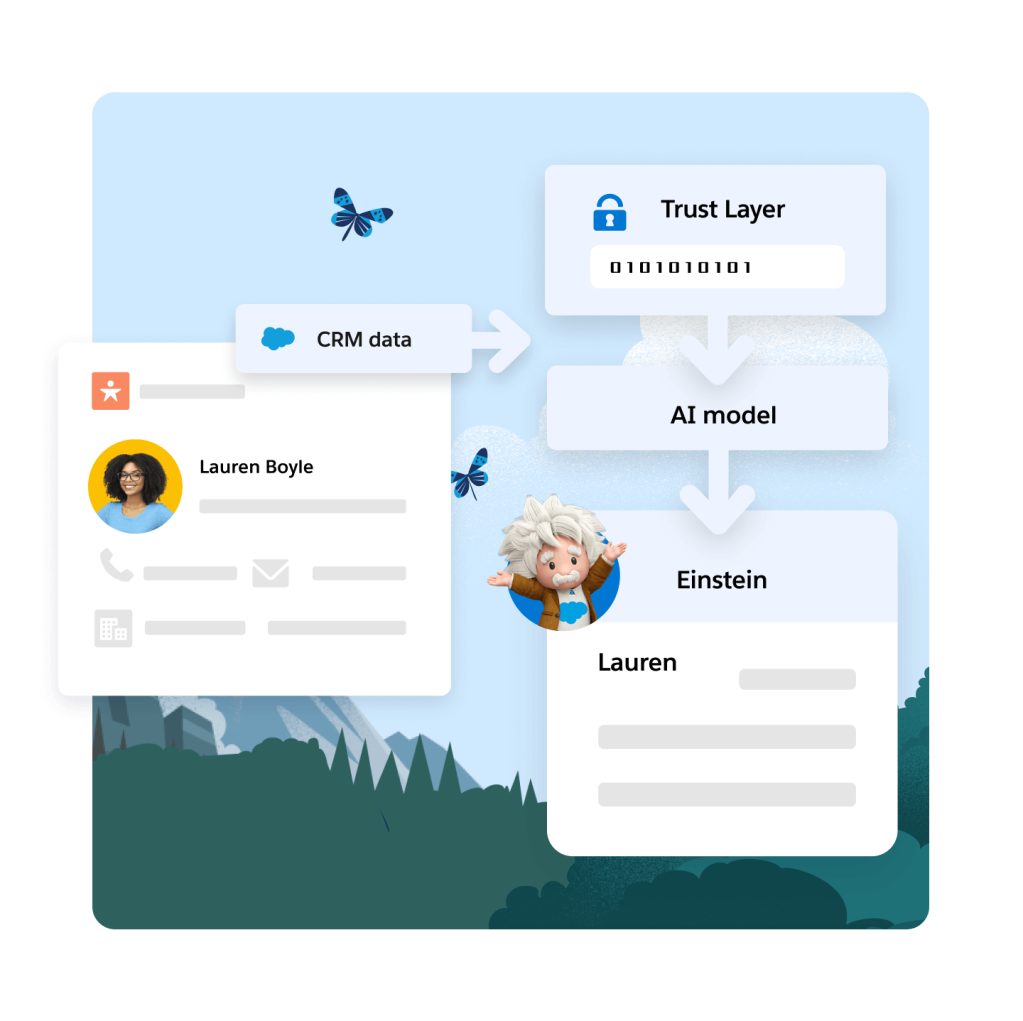

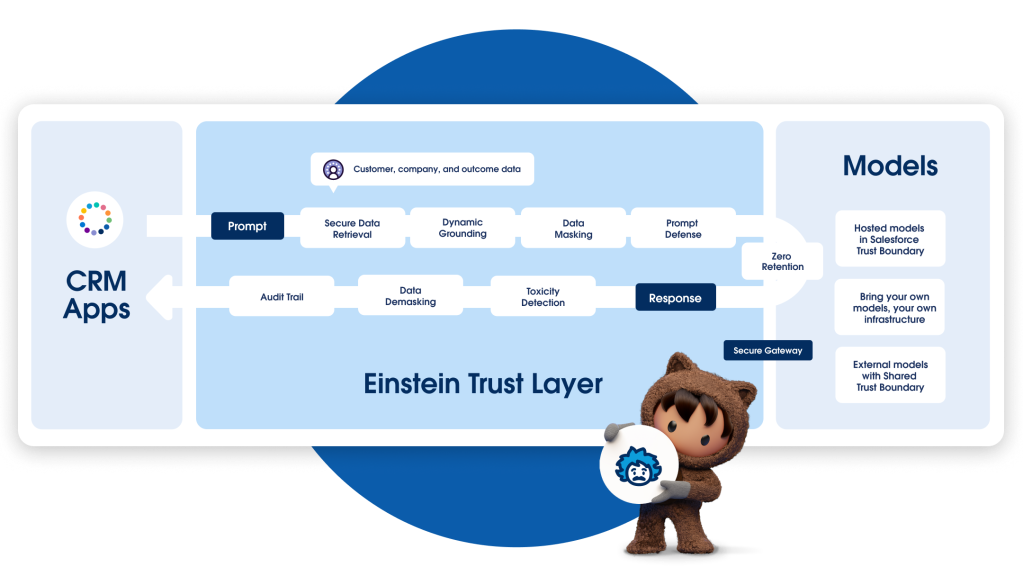

Einstein Trust Layer

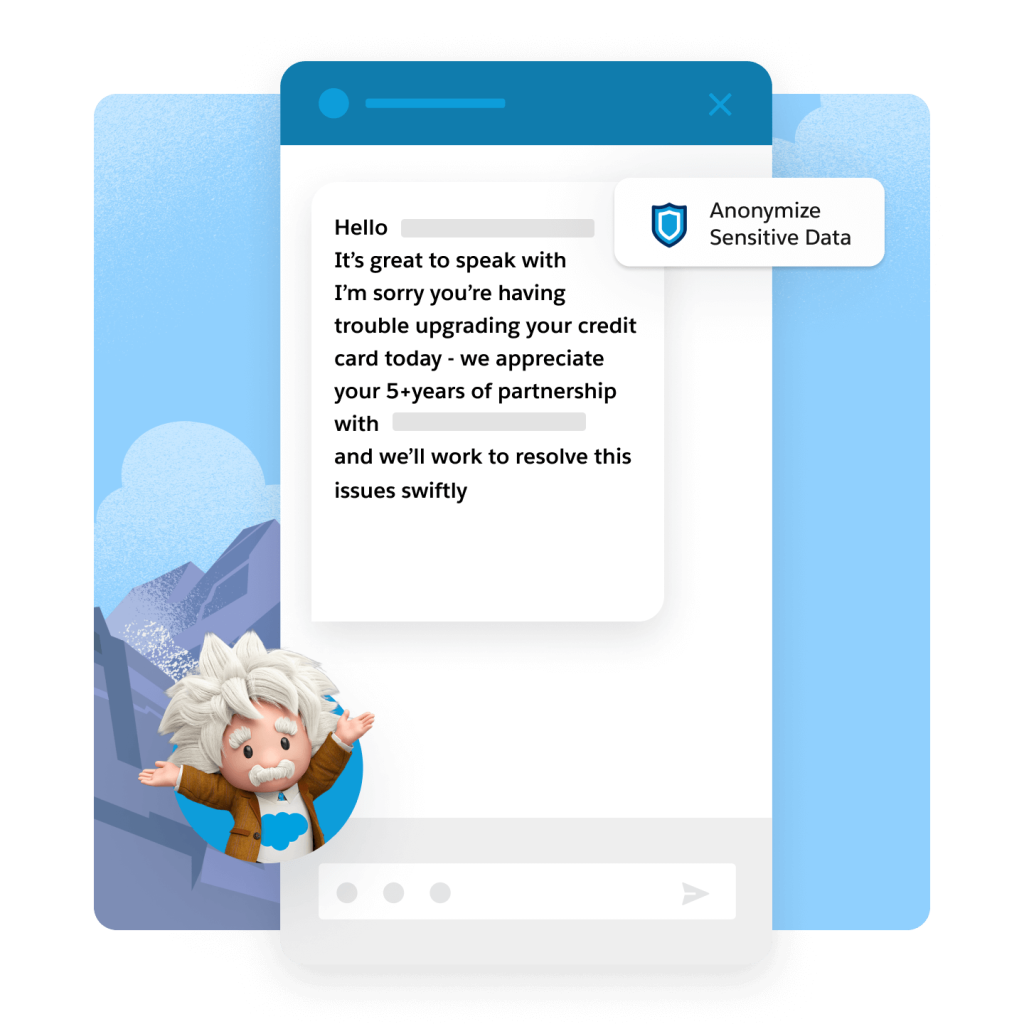

De Einstein Trust Layer is een veilige AI-architectuur die volledig is geïntegreerd in het Salesforce-platform. Het is gebaseerd op Hyperforce voor dataopslag en compliance, wat betekent dat onze productbeveiliging en beleidsregels garant staan voor een optimale bescherming. De Einstein Trust Layer is ontworpen voor zakelijke beveiligingsstandaarden en laat teams profiteren van generatieve AI, zonder enig risico voor hun klantdata.