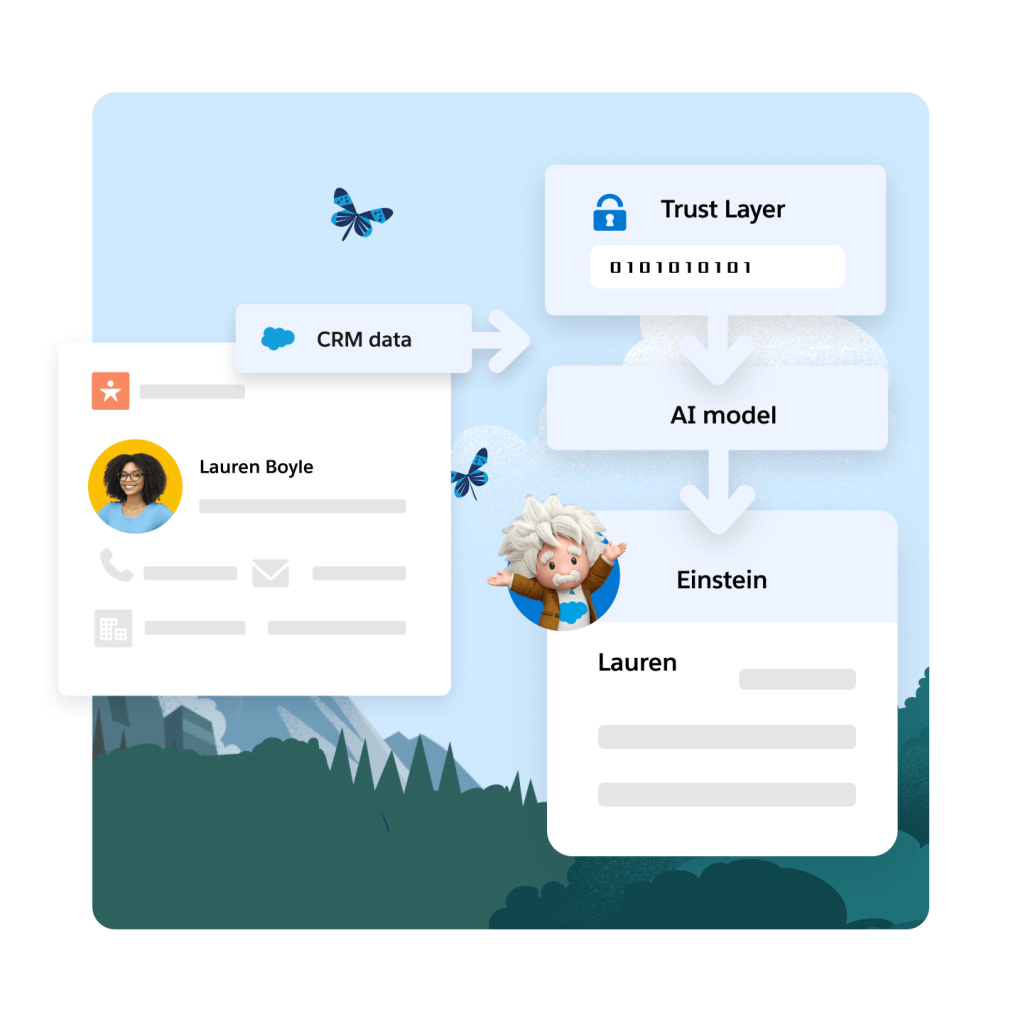

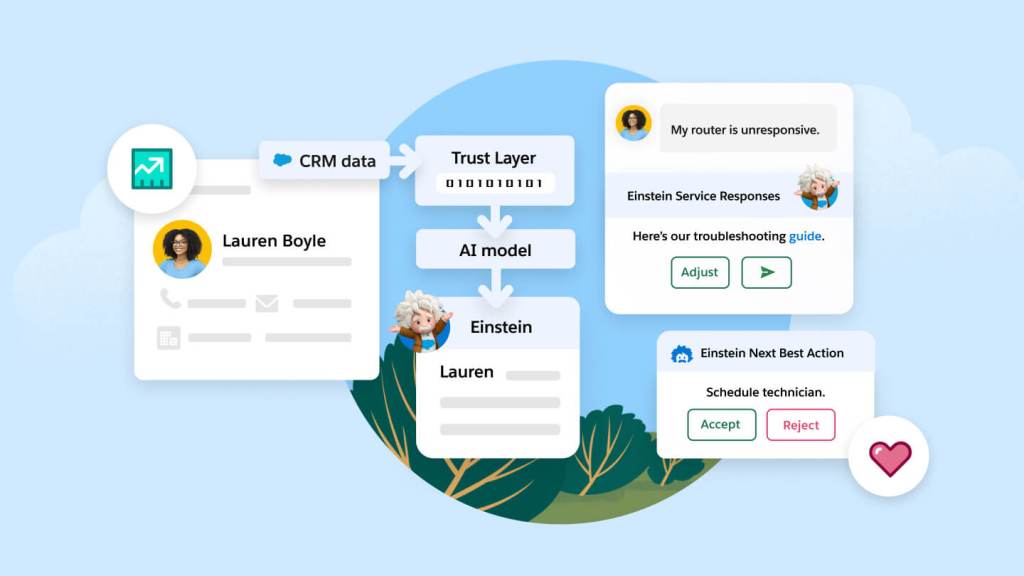

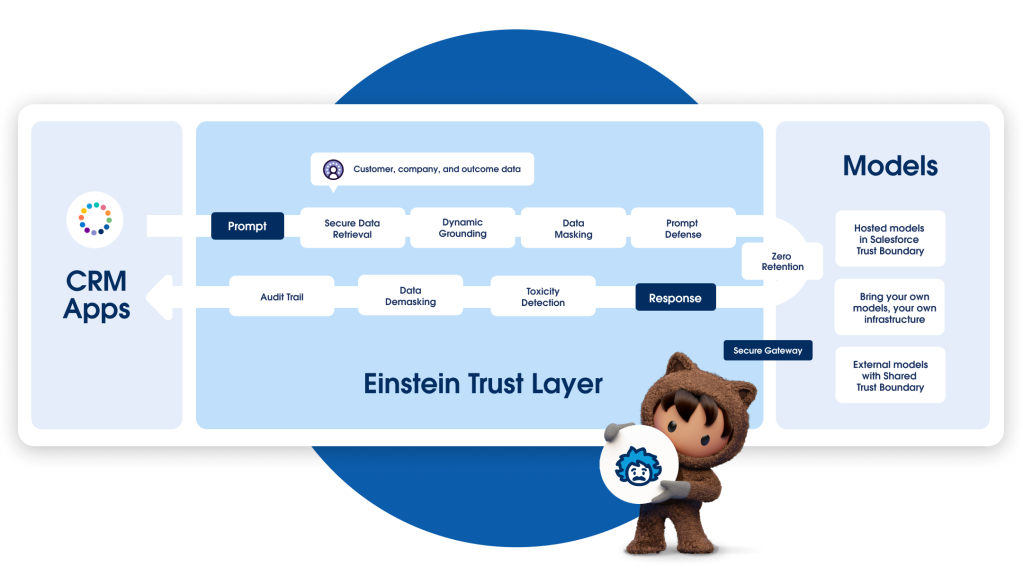

Einstein Trust Layer

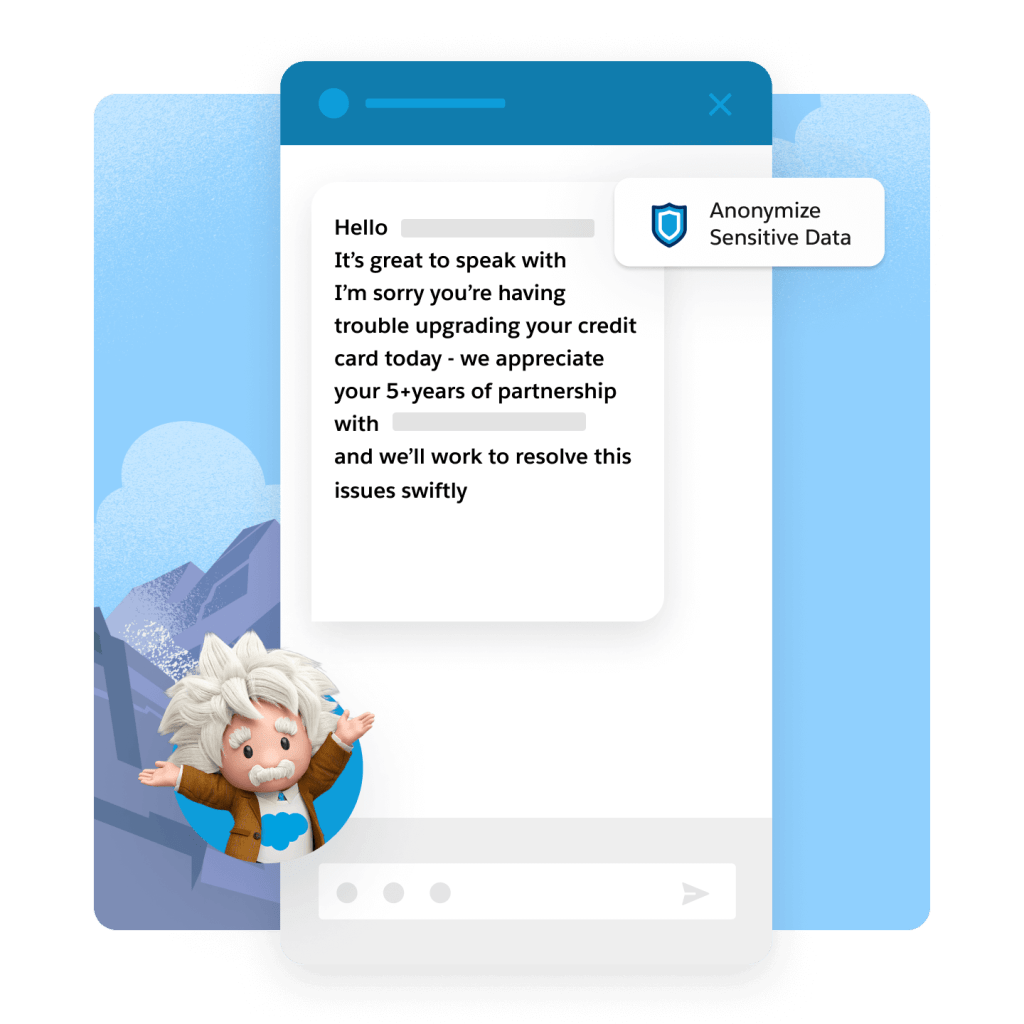

Einstein Trust Layer es una arquitectura de IA segura y desarrollada de forma nativa en Salesforce Platform. Está desarrollada en Hyperforce por motivos de cumplimiento y ubicación de los datos, Einstein Trust Layer cuenta con las mejores medidas de seguridad, tanto a nivel del producto como de nuestras políticas. Diseñada teniendo en mente los estándares empresariales de seguridad, Einstein Trust Layer permite a los equipos beneficiarse de la IA generativa sin poner en peligro los datos de sus clientes.