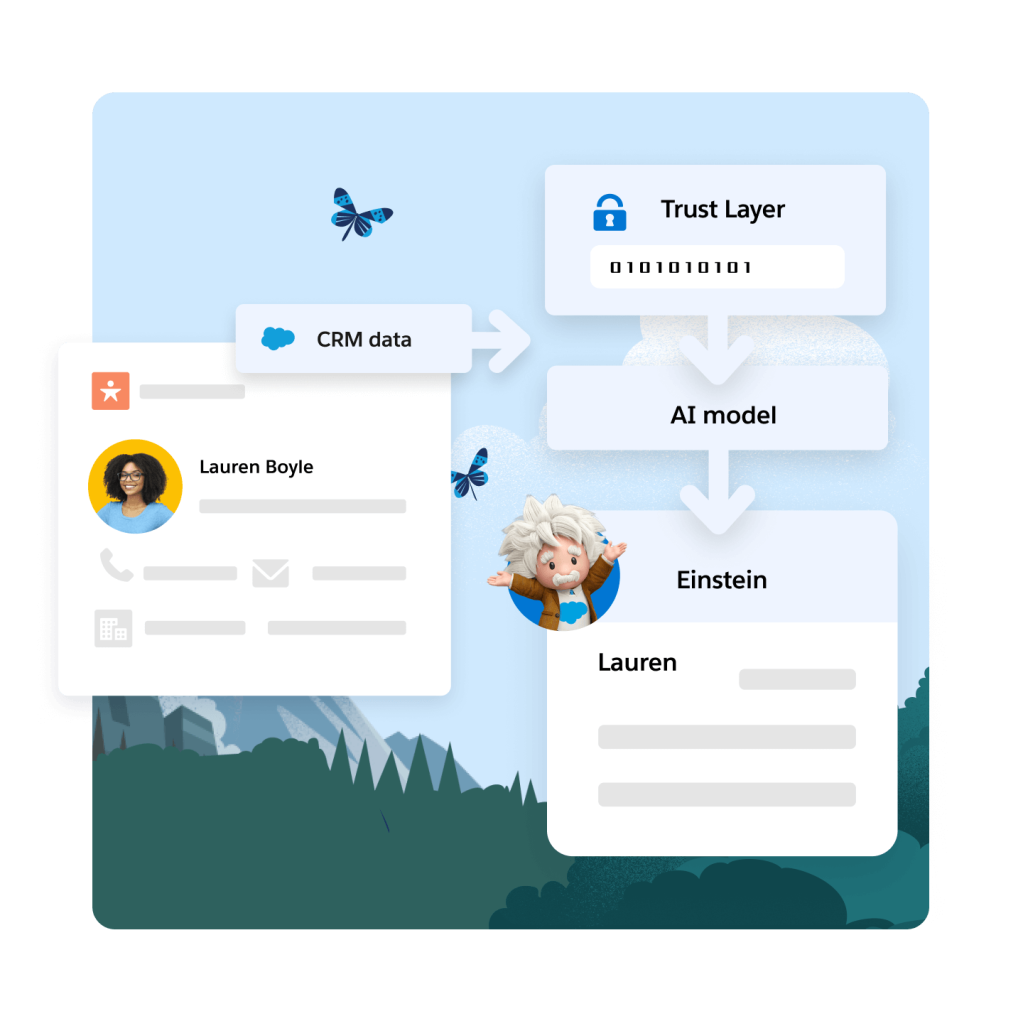

Einstein Trust Layer

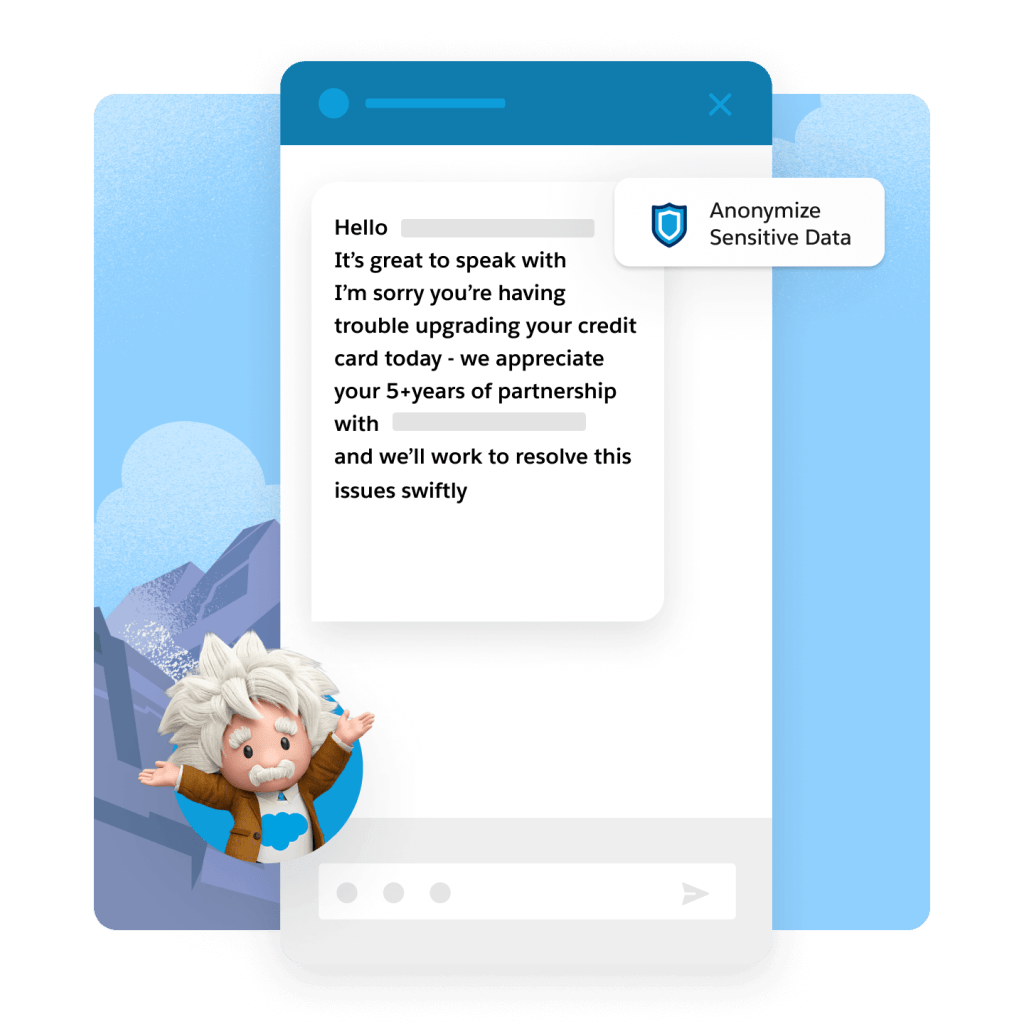

Einstein Trust Layer est une architecture de sécurisationd de l'IA, intégrée nativement à la plateforme Salesforce. Basée sur Hyperforce pour vous laisser choisir le pays de résidence de vos données, Einstein Trust Layer vous permet d'utiliser l'IA générative tout en protégeant et masquant les données de vos clients