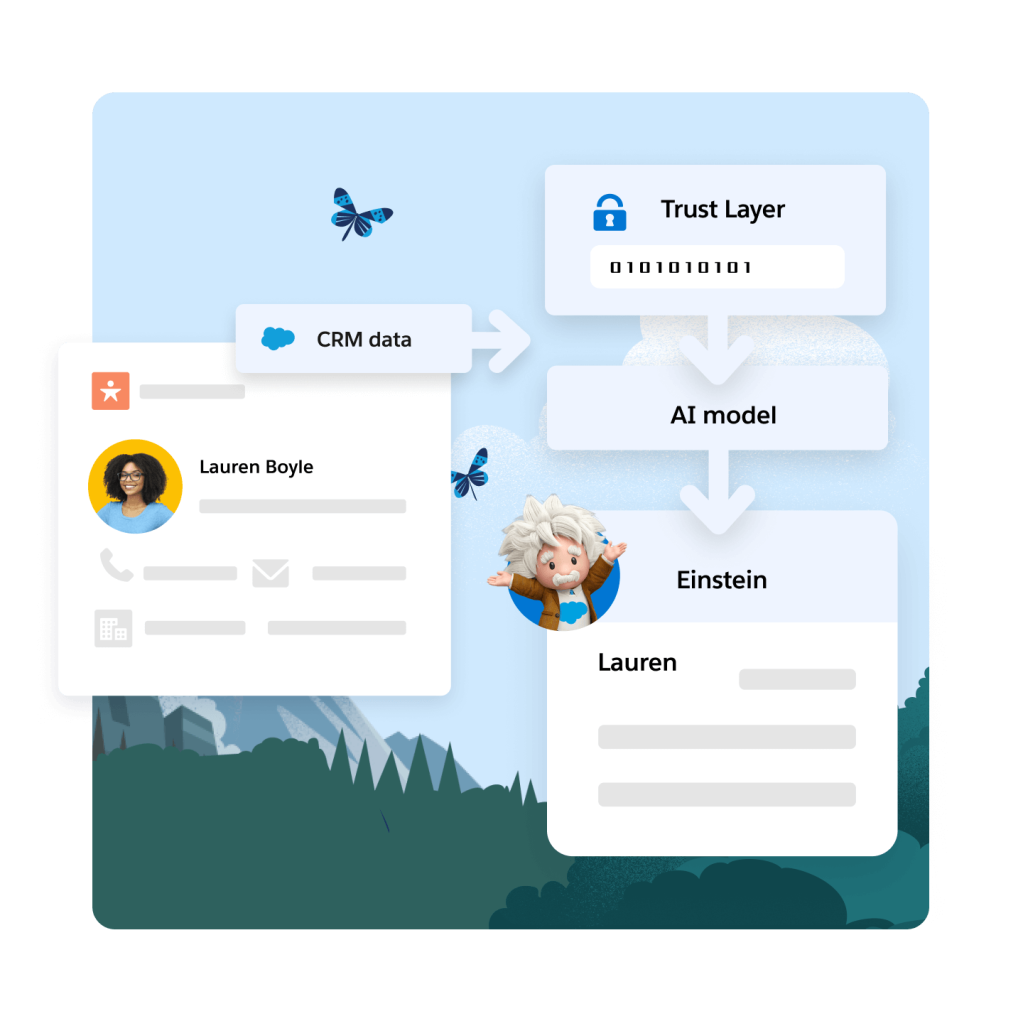

Einstein Trust Layer

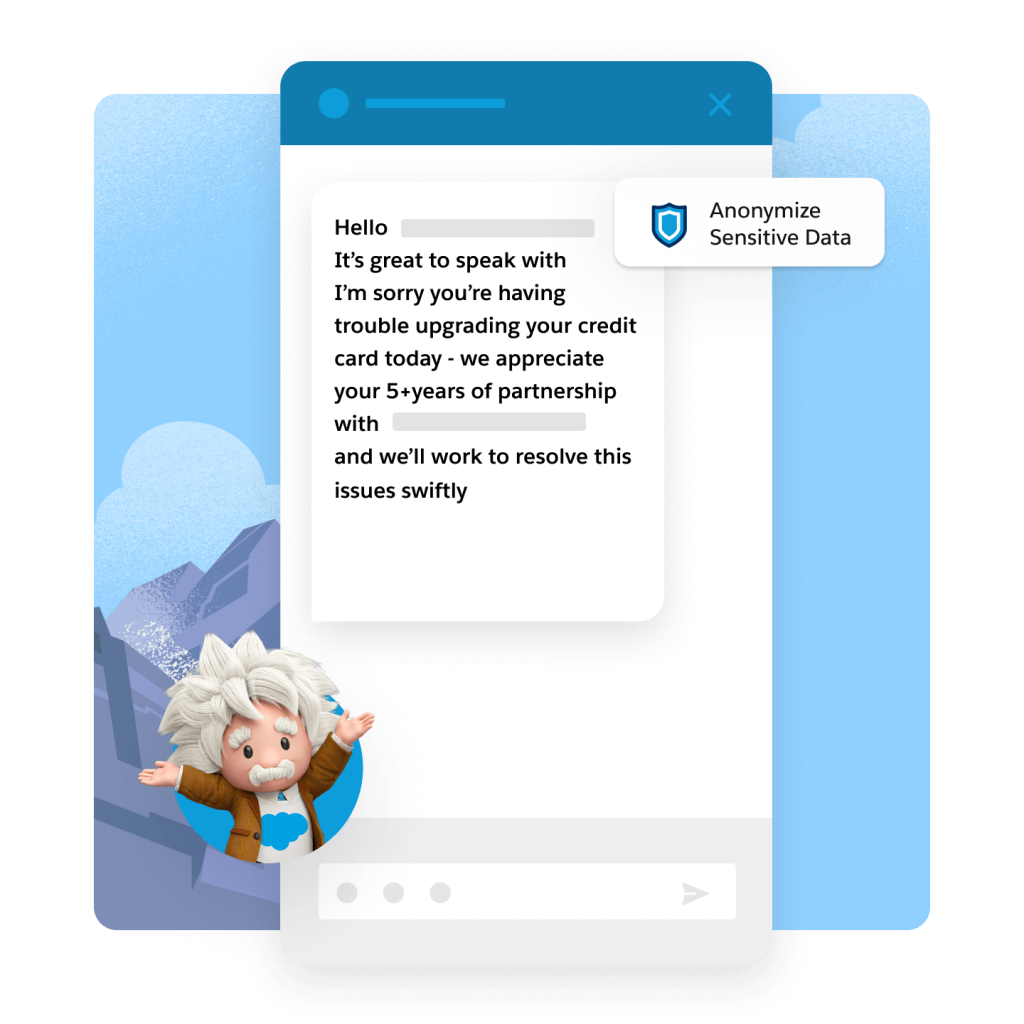

Der Einstein Trust Layer ist eine sichere KI-Architektur, die nativ in die Salesforce Platform integriert ist. Da er auf Hyperforce basiert, werden auch die Anforderungen an Data Residency, Compliance und die höchsten Sicherheitsstandards für Unternehmen erfüllt. So können Ihre Teams von generativer KI profitieren, während Ihre Kundendaten geschützt bleiben.