Rob Katz explique pourquoi la confiance est au cœur du développement de l’IA agentique

Peut-on vraiment faire confiance à des agents d’intelligence artificielle (IA) pour agir de manière responsable au nom des humains ?

Rob Katz, co-responsable de l’IA éthique chez Salesforce, estime que oui, à condition que les principes de transparence, d’explicabilité et de contrôle avec supervision humaine soient placés au cœur du développement des agents IA. Ces systèmes sont conçus pour accomplir une large gamme de tâches, de la réponse à des questions simples à la résolution de problèmes complexes, sans intervention humaine. Leur mise en œuvre dans les entreprises ouvre la voie à des capacités additionnelles quasiment illimitées pour renforcer les équipes, des capacités susceptibles de transformer les modèles organisationnels en profondeur.

Mais selon Katz, sans établir un véritable climat de confiance entre les agents et les collaborateurs en poste, les entreprises risquent de ne pas exploiter pleinement le potentiel de ces nouveaux outils.

Dans cet entretien, il partage sa vision des enjeux éthiques posés par l’IA et de la manière dont les entreprises peuvent concilier innovation et responsabilité. Il revient également sur la démarche de Salesforce pour mettre en place une IA agentique de confiance, notamment via des systèmes comme Agentforce, la couche agentique intégrée à la plateforme unifiée de Salesforce, conçue pour aider les entreprises à déployer ces technologies en toute confiance.

Quelles mesures les entreprises doivent-elles prendre pour garantir que l’IA fonctionne comme prévu ?

Tout repose sur une collaboration étroite entre humains et IA. La confiance dans le travail numérique sera un enjeu fondamental pour les organisations qui intègrent ces nouveaux agents. Personne ne souhaiterait collaborer avec un agent auquel il ne fait pas confiance.

Trois principes sont essentiels : la transparence, l’explicabilité et le contrôle. C’est sur cette base que les entreprises chercheront à instaurer la confiance : en s’assurant que leur main-d’œuvre numérique est compréhensible, traçable et maîtrisable.

Les collaborateurs resteront-ils toujours dans la boucle ?

Pas pour chaque microdécision.

Prenons un exemple : si je cherche à prendre rendez-vous avec un prestataire, deux agents IA peuvent très bien gérer les conflits d’agenda et proposer des créneaux compatibles. Dans ce type de situation, les paramètres sont clairs, l’environnement est maîtrisé, et je n’ai pas besoin de suivre chaque étape du processus.

Mais si l’agent IA agit en dehors de ce cadre, je veux pouvoir comprendre ce qui s’est passé — et avoir la possibilité d’ajuster mes paramètres. C’est précisément là qu’interviennent la transparence, l’explicabilité et le contrôle.

Nous entrons dans un monde où l’intervention humaine ne sera plus nécessaire à chaque étape, et ce futur est imminent. Pour autant, le rôle du collaborateur restera déterminant, en particulier pour superviser ces systèmes et intervenir dans les décisions à forte portée juridique ou stratégique.

Comment une entreprise peut-elle instaurer la confiance dans ses déploiements d’IA ?

Il est essentiel d’annoncer clairement la démarche à toutes les parties prenantes. Salesforce, comme d’autres acteurs engagés sur ces sujets, a été parmi les premiers à publier des principes pour un usage éthique et responsable de l’IA. Nous avons enrichi ces engagements avec cinq grands principes spécifiques au développement de l’IA générative, des principes qui restent pleinement pertinents dans cette nouvelle phase agentique.

Un second levier clé consiste à définir des règles d’usage précises. La politique d’utilisation acceptable de l’IA chez Salesforce stipule, par exemple, que l’IA ne peut être utilisée pour des cas à haut risque sans qu’un collaborateur valide la décision finale.

Les entreprises soucieuses d’établir la confiance anticipent aussi les risques potentiels liés à ces systèmes, et mettent en place des garde-fous pour limiter leur probabilité d’occurrence.

Quels sont les mécanismes de retour d’expérience utilisés par Salesforce pour renforcer la confiance dans l’IA agentique ?

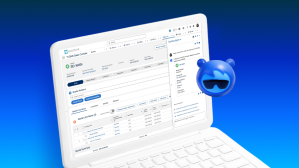

Le premier principe, c’est la transparence. Nous avons mis en place un ensemble clair de mentions et d’indications permettant à l’utilisateur de savoir, à tout moment, quand et comment une IA est utilisée. Ces éléments ont été élaborés avec nos équipes design et contenus, et sont systématiquement intégrés à tous nos produits.

Ensuite, vient l’explicabilité. Cela passe notamment par l’intégration de références, ou citations, dans les réponses générées par l’IA. Une citation, c’est simplement une source. Pas au sens académique, mais dans la logique de traçabilité : d’où vient cette information ? D’où provient cette réponse ? S’assurer que ces références soient solides et utiles est un levier central pour instaurer la confiance — et pour intégrer un mécanisme de feedback directement dans l’outil.

Un exemple simple et parlant : dans Slack, la fonctionnalité AI Recap propose un résumé de ce qui s’est dit dans un canal. Et il est possible de cliquer sur chaque élément pour accéder au message d’origine. Ce type de traçabilité est à la fois élémentaire et très efficace.

Comment s’assurer que les règles de développement responsable ne freinent pas l’innovation ?

C’est, selon moi, un faux dilemme. L’adoption de l’IA repose entièrement sur la confiance, et celle-ci exige des règles claires. Qu’il s’agisse de lois, de réglementations ou de politiques d’entreprise, ces cadres, s’ils sont bien conçus et guidés par une logique de confiance, favorisent l’innovation plutôt qu’ils ne la contraignent.

Ils définissent les règles du jeu dès le départ, ce qui permet aux équipes d’innover en sachant ce qui est attendu.

Qu’est-ce qui distingue la position de Salesforce sur la question de la confiance ?

Depuis nos débuts, nous demandons à nos clients de nous confier leurs données, en les hébergeant en toute sécurité dans notre cloud. En 1999, c’était une idée assez audacieuse – mais cette responsabilité, nous l’avons toujours prise au sérieux. C’est ce qui nous a permis de devenir un acteur de référence sur la question de la confiance.

Aujourd’hui encore, les principes de confiance, d’éthique et de protection des données sont profondément ancrés dans la culture de Salesforce. Il était donc naturel d’appliquer ces mêmes exigences à nos développements en intelligence artificielle. Bien sûr, nous cherchons en permanence à nous améliorer. Mais notre culture repose sur une conviction simple : la confiance est essentielle, à la fois pour notre activité et pour celle de nos clients.

Pour aller plus loin :

– Découvrez comment Salesforce bâtit la confiance dans l’ère de l’IA agentique

– Lisez comment le travail numérique transforme l’entreprise

– Consultez les principaux points de vigilance pour intégrer les agents IA de manière responsable