AI generativa: 5 linee guida per uno sviluppo responsabile

L’intelligenza artificiale generativa (AI) ha il potere di trasformare il nostro modo di vivere e lavorare. Ma l’AI generativa non è priva di rischi, bisogna imparare a farne un uso responsabile.

Salesforce Italia

L’intelligenza artificiale generativa (AI) ha il potere di trasformare il nostro modo di vivere e lavorare in modo profondo e metterà alla prova anche le aziende più innovative per gli anni a venire.

Ma l’AI generativa non è priva di rischi. Comprende molte cose giuste ma anche molte cose sbagliate. Mentre le aziende si affrettano a portare questa tecnologia sul mercato, è fondamentale farlo in modo inclusivo e intenzionale. Non è sufficiente fornire le capacità tecnologiche dell’AI generativa, dobbiamo dare priorità all’innovazione responsabile per aiutare a guidare il modo in cui questa tecnologia trasformativa può e deve essere utilizzata, e garantire che i nostri dipendenti, partner e clienti abbiano gli strumenti necessari per sviluppare e utilizzare queste tecnologie in modo sicuro, accurato ed etico.

L’intelligenza artificiale generativa in Salesforce

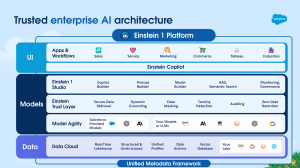

Il potenziale dell’intelligenza artificiale generativa in Salesforce e, più in generale, nella tecnologia aziendale, è enorme.

L’AI è già parte integrante della piattaforma Customer 360 e le nostre tecnologie Einstein AI forniscono quasi 200 miliardi di previsioni ogni giorno nelle applicazioni aziendali di Salesforce, tra cui:

- Vendite, in cui sono utilizzate le intuizioni dell’intelligenza artificiale per identificare i migliori passi da compiere e chiudere le trattative più velocemente.

- Assistenza, in cui è utilizzata l’intelligenza artificiale per avere conversazioni simili a quelle umane e fornire risposte a domande e compiti ripetitivi, liberando gli agenti per gestire richieste più complicate.

- Marketing, che sfrutta l’intelligenza artificiale per comprendere il comportamento dei clienti e personalizzare i tempi, gli obiettivi e i contenuti delle attività di marketing.

- Commerce, che utilizza l’intelligenza artificiale per creare esperienze di acquisto altamente personalizzate e un commercio elettronico più intelligente.

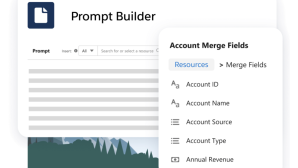

Ora l’AI generativa ha il potenziale per aiutare i nostri clienti a connettersi con il pubblico in modi nuovi e più personalizzati in molte interazioni di vendita, assistenza clienti, marketing, commercio e IT. Stiamo anche esplorando l’uso di codice generato dall’intelligenza artificiale per aiutare i nostri clienti, anche quelli che non hanno sviluppatori Salesforce certificati, a scrivere codice di alta qualità in modo più veloce, utilizzando meno righe di codice e quindi richiedendo meno CPU.

Linee guida per un’intelligenza artificiale generativa affidabile

Come per tutte le nostre innovazioni, stiamo inserendo nei nostri prodotti delle linee guida etiche per aiutare i clienti a innovare in modo responsabile e a individuare potenziali problemi prima che si verifichino.

Date le enormi opportunità e le sfide che stanno emergendo in questo spazio, stiamo sviluppando i nostri Principi dell’IA affidabile con una nuova serie di linee guida incentrate sullo sviluppo e l’implementazione responsabile dell’IA generativa.

Siamo ancora agli albori di questa tecnologia trasformativa e queste linee guida sono ancora in fase di sviluppo. Tuttavia, ci impegniamo a imparare e a collaborare con gli altri per trovare soluzioni.

Di seguito sono indicate cinque linee guida che stiamo utilizzando per guidare lo sviluppo di un’AI generativa affidabile, sia in Salesforce che all’esterno.

- Precisione. Dobbiamo fornire risultati verificabili che bilancino l’accuratezza, la precisione e il richiamo dei modelli, consentendo ai clienti di addestrare i modelli sui propri dati. Dobbiamo comunicare quando c’è incertezza sulla veridicità della risposta dell’IA e consentire agli utenti di convalidare queste risposte. Questo può essere fatto citando le fonti, spiegando perché l’AI ha dato le risposte che ha dato (ad esempio, prompt della catena riflessione), evidenziando le aree da verificare (ad esempio, statistiche, raccomandazioni, date) e creando barriere di sicurezza che impediscano ad alcune attività di essere completamente automatizzate (ad esempio, inviare il codice in un ambiente di produzione senza una revisione umana).

- Sicurezza. Come per tutti i nostri modelli di AI, dovremmo compiere tutti gli sforzi possibili per mitigare le distorsioni, la tossicità e i risultati dannosi, conducendo valutazioni di distorsione, spiegabilità e robustezza e facendo red teaming. Dobbiamo inoltre proteggere la privacy di ogni informazione di identificazione personale (PII) presente nei dati utilizzati per la formazione e creare delle barriere per evitare ulteriori danni (ad esempio, forzare la pubblicazione del codice in una sandbox piuttosto che spingerlo automaticamente in produzione).

- Onestà. Quando raccogliamo i dati per addestrare e valutare i modelli, dobbiamo rispettare la provenienza dei dati e assicurarci di avere il consenso all’uso dei dati (ad esempio, open-source, forniti dagli utenti). Dobbiamo anche mostrare trasparenza sul fatto che un’IA ha creato un contenuto quando questo viene distribuito autonomamente (ad esempio, la risposta di un chatbot a un consumatore, l’uso di filigrane).

- Empowerment. In alcuni casi è meglio automatizzare completamente i processi, ma in altri casi l’AI dovrebbe svolgere un ruolo di supporto all’uomo o in cui è necessario il giudizio umano. Dobbiamo individuare il giusto equilibrio per potenziare le capacità umane e rendere queste soluzioni accessibili a tutti (ad esempio, generare testo alternativo da accompagnare alle immagini).

- Sostenibilità. Mentre ci sforziamo di creare modelli più accurati, dovremmo sviluppare modelli di dimensioni adeguate, ove possibile, per ridurre la nostra impronta di carbonio. Nel caso dei modelli di AI, la grandezza non corrisponde sempre a qualità. In alcuni casi, modelli più piccoli e meglio addestrati sono migliori di modelli più grandi e scarsamente addestrati.

Creare un’AI generativa di cui ci si possa fidare

Leggi le intuizioni del Chief Scientist di Salesforce.

Scopri di più sull’AI affidabile in Salesforce, compresi gli strumenti che forniamo ai nostri dipendenti, clienti, comunità e partner per sviluppare e utilizzare l’AI in modo responsabile, accurato ed etico