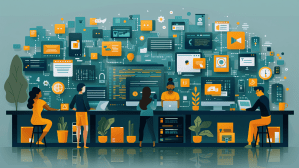

De zeven pijlers van een agentische organisatie

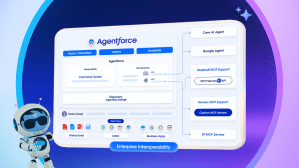

In dit vlekkeloos werkende ecosysteem veranderen gesprekken in acties, maken AI-agents deel uit van de workflows en kan het personeelsbestand worden opgeschaald of afgeschaald op basis van de klantvraag.