Bleu ou jaune ? « En savoir plus » ou « Lire plus » ? Envoyer cet e-mail un lundi ou un mercredi ? L'apprentissage de ses essais et erreurs constitue un moyen de déterminer les meilleurs résultats possibles de vos efforts de marketing numérique. Mais l'A/B Testing, également appelé « test fractionné », est plus rapide, plus efficace et capable de produire des données concrètes pour aider votre équipe à prendre des décisions éclairées et efficaces. Lisez la suite pour savoir comment mettre en œuvre des A/B Tests dans le cadre de vos actions marketing.

Ce que nous allons aborder :

- Définition de l'A/B Testing (ou test fractionné)

- L'A/B Testing concrètement

- Pourquoi utiliser l'A/B Testing ?

- Qu'est-ce que la sélection aléatoire dans l'A/B Testing ?

- Qu'est-ce que la signification statistique dans les tests fractionnés ?

- Générer des idées et créer des hypothèses

- Élaborer votre A/B Test

- Exécuter et surveiller les A/B Tests

- Tirer des enseignements de l'analyse des résultats des A/B Tests

Définition de l'A/B Testing (ou test fractionné)

Définition : l'A/B testing est la méthode d'optimisation numérique consistant à comparer deux variantes d'un même contenu (page web, e-mail ou publicité…) afin de mesurer leur efficacité respective. En soumettant ces versions de manière aléatoire à des segments d'audience identiques, les entreprises collectent des données statistiques sur les comportements des utilisateurs. L'analyse des résultats permet d'identifier avec précision les éléments qui favorisent l'atteinte d'objectifs spécifiques, tels que l'augmentation du taux de clic ou de conversion, sur la base de preuves tangibles plutôt que d'hypothèses. C'est l'approche idéale pour optimiser continuellement vos performances et offrir à chaque client l'expérience la plus pertinente possible.

L'A/B Testing concrètement

Les A/B Tests peuvent améliorer l'efficacité opérationnelle. Soutenue par des données, la bonne décision peut devenir évidente après environ une semaine d'analyse de résultats. En testant plutôt qu'en devinant, les équipes créatives, marketing et opérationnelles gagnent un temps précieux qu'elles peuvent consacrer à d'autres tâches prioritaires.

Le coût financier d'une mauvaise décision et les éventuelles opportunités manquées peuvent être minimisés grâce à l'AB Testing. De même, les enseignements tirés de ces tests peuvent être inestimables. Si vous testez un bouton bleu par rapport à un bouton jaune réparti de manière homogène auprès de votre audience, et que l'A/B Testing révèle que le bouton devrait effectivement être bleu, le risque d'exposer les utilisateurs à une expérience moins efficace est réduit de moitié.

Certaines des entreprises les plus innovantes au monde s'appuient sur des A/B Tests pour prendre leurs décisions en matière de marketing et de produits. L'expérimentation fait tellement partie intégrante de certaines entreprises qu'elles ont développé leurs propres outils personnalisés pour leurs besoins en matière de tests. Chez LinkedIn , les mises en production ne se font pas sans tests fractionnés. Netflix est également réputé pour mener des expériences sur son processus d'inscription et l'efficacité de son contenu ; l'entreprise encourage ses designers à penser comme des scientifiques . Google a mené 17 523 expériences en conditions réelles qui ont donné lieu à 3620 lancements en 2019. Jeff Bezos a fait la fameuse déclaration suivante : « Notre réussite dépend du nombre d'expériences que nous réalisons par an, par mois, par semaine, par jour ».

Pourquoi utiliser l'A/B Testing ?

Lors d'un A/B Test sur une page web, le trafic est généralement réparti entre les utilisateurs qui verront le contrôle, c'est-à-dire la version de référence (par exemple, le bouton bleu), et ceux qui verront la variation, c'est-à-dire la variante testée (le bouton jaune). Contrairement aux tests qualitatifs ou à la recherche où les utilisateurs nous disent ce qu'ils vont faire, lors d'un A/B Test, des données sont collectées sur ce que les utilisateurs font réellement lorsqu'ils choisissent entre le contrôle et la variation.

Sans entrer dans les détails mathématiques de la réalisation d'un A/B Test, il existe deux principes fondamentaux que chacun doit comprendre en matière d'expérimentation : la sélection aléatoire et la signification statistique.

Qu'est-ce que la sélection aléatoire dans l'A/B Testing ?

Pour que les résultats soient fiables, les utilisateurs auprès desquels la variation est présentée doivent être représentatifs de la base d'utilisateurs ciblée. Par exemple, dans le contexte d'un magasin de chaussures, il peut s'agir de tous les utilisateurs souhaitant acheter une paire de bottes. Dans la plupart des cas, le nombre d'utilisateurs est réparti de manière égale entre le contrôle et la variation. C'est ce que nous entendons par sélection aléatoire. Cette méthode est généralement utilisée dans les A/B Tests pour éviter tout biais. Notez toutefois que, parfois, seule une petite partie des utilisateurs est sélectionnée pour la variation afin de minimiser les risques.

Notre réussite dépend du nombre d'expériences que nous réalisons par an, par mois, par semaine, par jour.

Jeff Bezos , PDG d'Amazon

La plupart des logiciels commerciaux capables d'exécuter des A/B Tests dans différents canaux marketing (y compris Marketing Cloud) intègrent normalement une fonctionnalité de sélection aléatoire afin que les spécialistes marketing et les non-techniciens puissent exécuter les tests facilement.

Qu'est-ce que la signification statistique dans les tests fractionnés ?

La signification statistique est la mesure de la probabilité d'un résultat, qu'il soit exact ou simplement dû à la chance ou au hasard. Par exemple, si un analyste déclare une signification statistique de 90 % pour le résultat d'un test faisant état d'une augmentation de 5 % du taux de conversion, cela signifie que vous pouvez être sûr à 90 % que les résultats de ce test sont fiables.

L'analyse et la recherche contribuent à l'efficacité des tests

Albert Einstein a dit un jour : « La formulation d'un problème est souvent plus essentielle que sa solution, celle-ci n'étant souvent qu'une question d'habileté mathématique ou expérimentale ». La première et la plus importante étape d'une expérience consiste à identifier les problèmes clés (ou les objectifs commerciaux mesurables) et à les valider par l'analyse et la recherche.

Supposons qu'une équipe web apprenne que l'une de leurs landing pages est peu performante. Plutôt que de se lancer dans des solutions et des expérimentations aléatoires en modifiant les images, le texte ou la structure de la page, l'équipe doit d'abord examiner les données pour identifier le problème. En examinant l'analytique de la page et les données des utilisateurs, ils constatent que le problème provient du call-to-action (CTA) principal. C'est ce type de recherche réfléchie et ciblée qui constitue l'analyse nécessaire avant la mise en place du processus d'A/B Testing.

Générer des idées et créer des hypothèses

Une fois le problème identifié et validé, commencez à générer des solutions qui résoudront le problème commercial rencontré. Elles doivent être accompagnées d'hypothèses sur les résultats et l'impact possibles.

Par ailleurs, il est important de faire la différence entre les idées et les hypothèses. Une idée est une opinion sur le quoi, le où, le qui et le comment d'une expérience. L'hypothèse est la raison pour laquelle l'idée, si elle est mise en œuvre, produira de meilleurs résultats que la situation actuelle par rapport à l'objectif donné. Par exemple, changer la couleur du bouton en jaune est une idée. L'hypothèse est que le contraste élevé entre la couleur du bouton et celle de l'arrière-plan permettra aux utilisateurs de mieux voir le bouton et d'augmenter le nombre de clics.

Établir des priorités et séquences pour déterminer ce qu'il faut tester et à quel moment

Lorsque vous essayez de résoudre un problème de communication numérique, il est probable que vous souhaitiez effectuer de nombreux tests et mettre à l'épreuve plusieurs hypothèses. Toutefois, pour obtenir des données de test fiables, vous ne pouvez résoudre qu'une seule hypothèse à la fois.

C'est à ce moment-là qu'il faut commencer à établir des priorités et à séquencer les tests. La plupart des programmes d'expérimentation réussis sont passés par une pondération de ces décisions en fonction de l'importance stratégique, de l'effort, de la durée et de l'impact. Certains programmes de grande envergure attribuent une note à chacun des critères. Le test qui obtient le score le plus élevé est placé en tête de file. Cela dit, aucun système de notation n'est parfait et ils doivent tous être affinés au fil du temps.

Finaliser votre plan de test

Une fois que vous savez quel test effectuer, il est préférable de développer un plan de test solide en amont. Un plan d'A/B Testing complet doit comprendre les informations suivantes :

- Le problème que vous essayez de résoudre

- Un objectif SMART (Spécifique, Mesurable, Atteignable, Réaliste et Temporellement défini)

- L'hypothèse à tester

- Les principaux indicateurs de réussite (comment les résultats seront mesurés)

- L'audience (auprès de qui et de combien de personnes vous effectuez le test)

- Le lieu (là où le test sera effectué)

- Le levier (ce qui change entre le contrôle et la variation)

- La durée de test permettant d'atteindre la signification statistique prédéterminée : la durée sera influencée par la répartition 50/50 ou 80/20 (qui dépend de votre tolérance au risque)

Un plan bien documenté assure la transparence, ce qui vous aide à obtenir un bon alignement au sein de l'organisation et à réduire les interférences avec d'autres tests. Ceci est particulièrement important si vous travaillez dans une grande organisation où de nombreuses équipes peuvent effectuer des tests simultanément.

Élaborer votre A/B Test

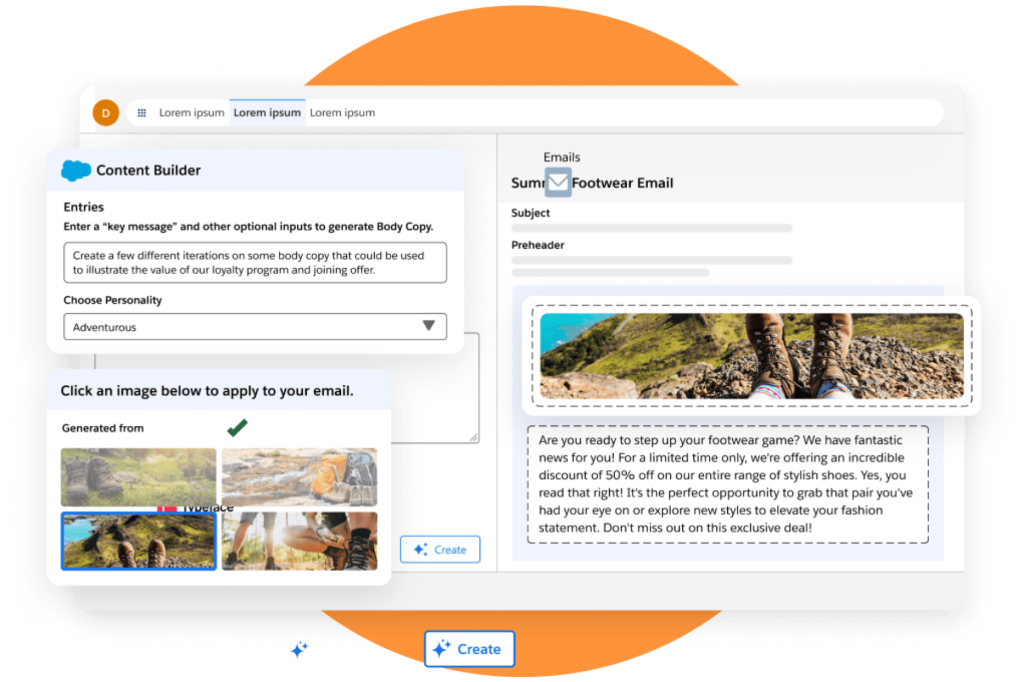

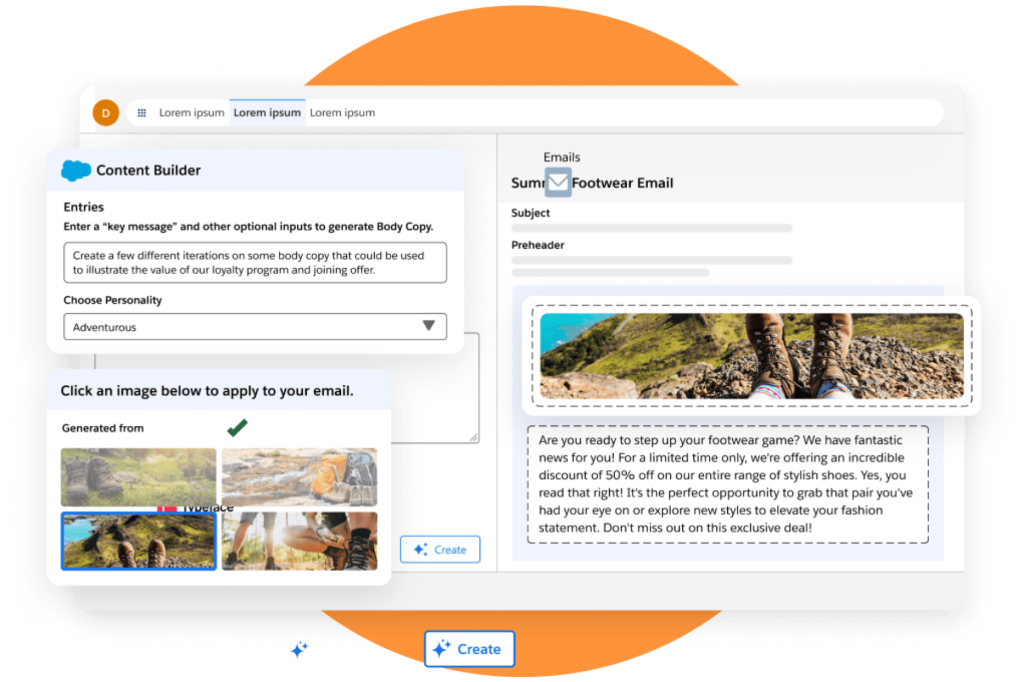

Une fois votre plan approuvé, il est temps de commencer à créer le test. Si vous modifiez la couleur, l'image ou le texte d'un bouton sur une page web, utilisez des logiciels et des services spécialisés dans l'A/B Testing. Des produits tels que Marketing Cloud Personalization dans Marketing Cloud permettent aux utilisateurs de modifier les couleurs dans le cadre d'un A/B Test à l'aide d'un éditeur visuel, de sorte qu'aucune compétence de codage n'est requise. Vous pouvez également tester les lignes d'objet des e-mails directement dans le produit.

S'il y a des éléments orientés clients, il est conseillé de recourir au design/UX pour s'assurer que les changements sont conformes à la marque et aux normes d'accessibilité de votre entreprise. S'il s'agit d'un test plus complexe impliquant des modifications du code, demandez à votre équipe de développement logiciel de procéder à une révision du code avant de lancer le test. Et si votre entreprise en a les moyens, faites passer le test par un contrôle qualité avant son lancement.

Exécuter et surveiller les A/B Tests

Une fois que vous avez appuyé sur le bouton de lancement, le travail n'est qu'à moitié fait. Les expériences doivent être contrôlées régulièrement pour s'assurer qu'elles se déroulent correctement, surtout si elles durent longtemps. Parfois, un changement de position d'un composant testé peut interrompre l'allocation du trafic vers la variation. Les mises en production du backend peuvent entraîner un dysfonctionnement de l'outil de test ou l'arrêt de l'envoi de données vers et depuis l'outil de test. Un contrôle régulier permettra de détecter les défaillances le plus rapidement possible. Un outil de visualisation des données tel que Tableau peut être utile pour regrouper les données et fournir une vue d'ensemble plus complète du test.

Dans les A/B Tests traditionnels, vous fixez une durée de test, puis vous n'arrêtez pas le test tant qu'il n'a pas atteint le jour ou le volume cible. Toutefois, si le résultat intermédiaire penche fortement dans un sens (par exemple, que le taux de conversion de la variation est systématiquement bien inférieur à celui du contrôle et qu'il y a de fortes raisons de penser qu'il ne s'améliorera pas avec le temps), l'entreprise peut décider de mettre fin prématurément au test afin de préserver sa pérennité.

Tirer des enseignements de l'analyse des résultats des A/B Tests

Un rapport d'expérimentation doit mettre en évidence la signification des données. Les analystes de l'expérience doivent interpréter les données de manière objective et « raconter l'histoire » qui se cache derrière les chiffres de manière qualitative. Plus important encore, il est essentiel de fournir des recommandations sur les mesures à prendre pour mieux comprendre le comportement des utilisateurs. Ces recommandations peuvent servir de base pour un prochain A/B Test.

À ce stade, le cycle de test et d'apprentissage itératif s'achève et le test suivant peut commencer.

Et maintenant?

Gardez à l'esprit qu'un A/B Test n'est pas un échec s'il ne s'est pas déroulé comme vous l'aviez prévu. Cela signifie simplement que l'hypothèse n'a pas été prouvée statistiquement. Il n'est pas raisonnable de croire que vos idées et vos pratiques seront justes 100 % du temps. En concevant, en exécutant, en contrôlant et en analysant correctement vos tests, vous apprendrez toujours quelque chose en cours de route. Vous en sortirez donc toujours gagnant.

Restez à jour avec les dernières tendances et insights du marketing.

Prêt à passer à l'étape suivante avec Marketing Cloud ?

Solliciter un expert

Merci de préciser votre demande afin que le service afférent vous contacte plus rapidement.

Voir la démo

Découvrez en vidéo les fonctionnalités de Marketing Cloud.

Profitez des meilleurs conseils

Abonnez-vous pour recevoir des ressources sélectionnées spécialement pour vous directement dans votre boîte de réception.